使用OLLAMA+ChatBoxAi.app5分钟体验deepseek-r1模型

某些场景下可能希望构建一个完全本地离线可用的大模型,方法很多,模型也很多,比如 qwen、qwen2、llama3等,最简单快捷的首推使用 ollama 部署,模型选用 qwen 或 qwen2,针对中文任务效果更好。

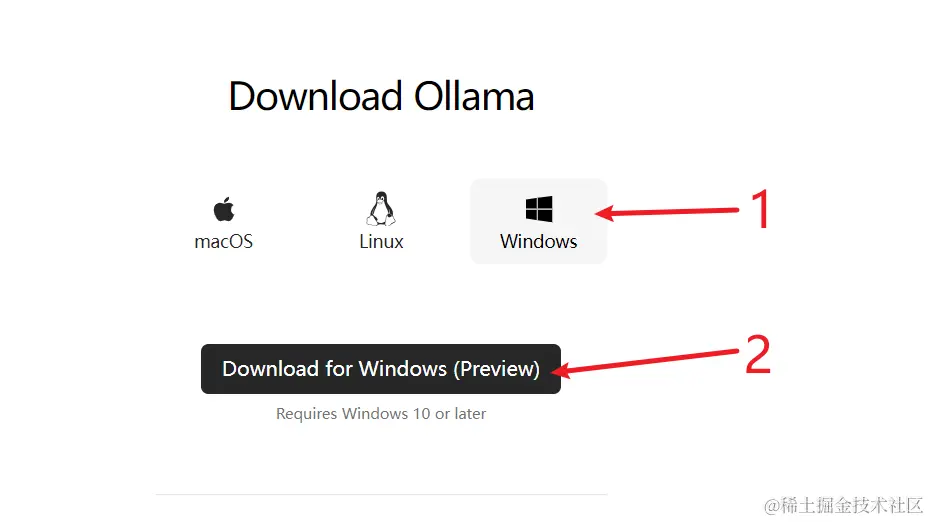

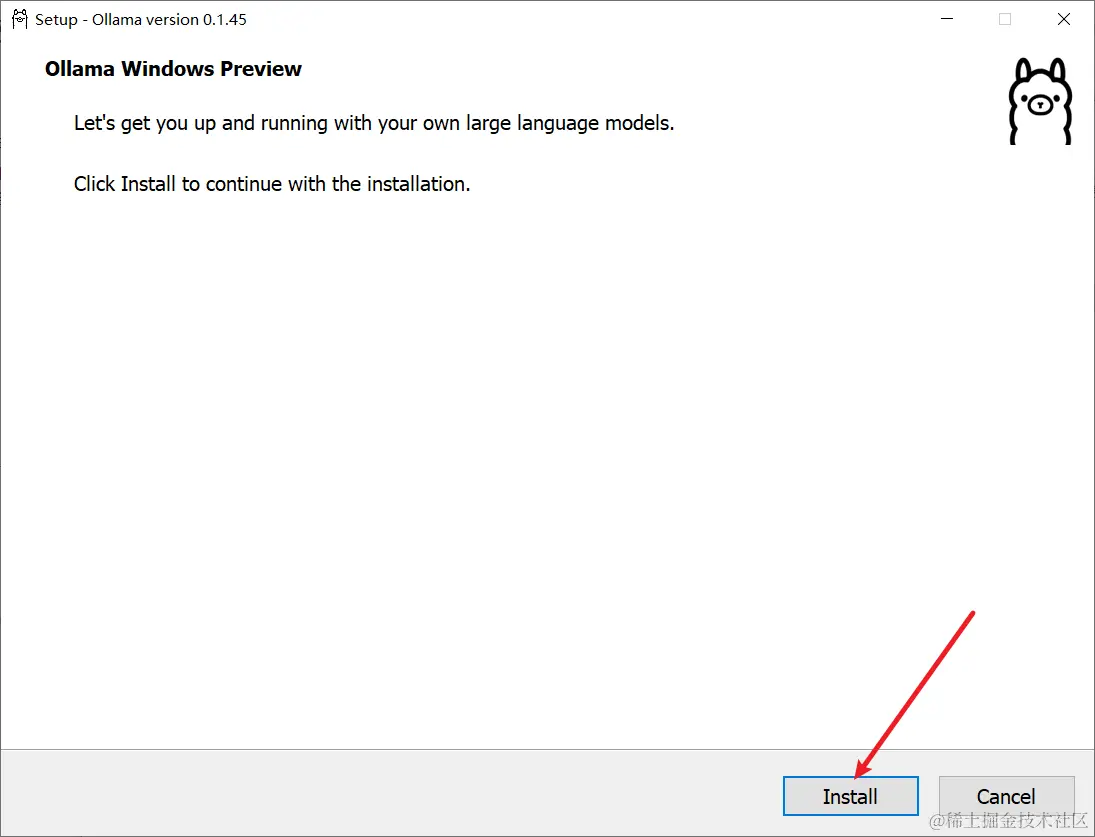

首先下载 ollama 双击安装(277MB)

ollama下载地址: www.ollama.com/download

下载后双击安装

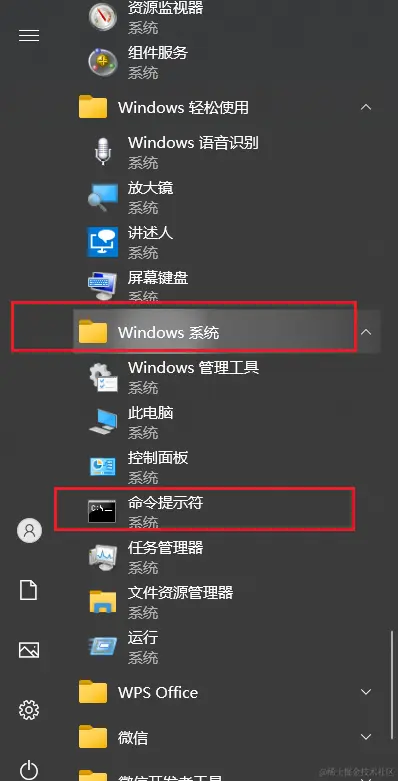

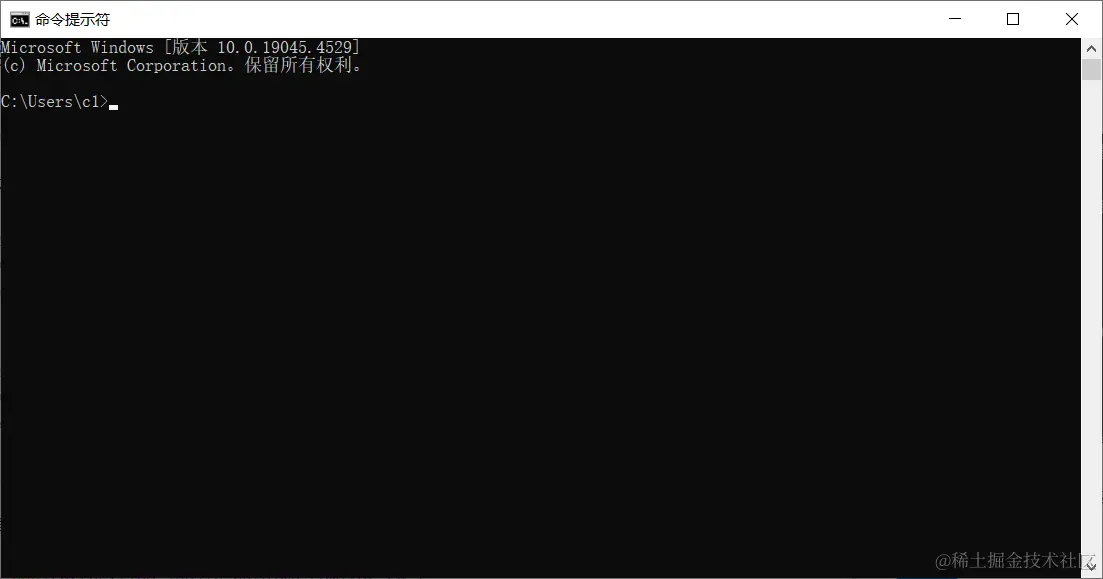

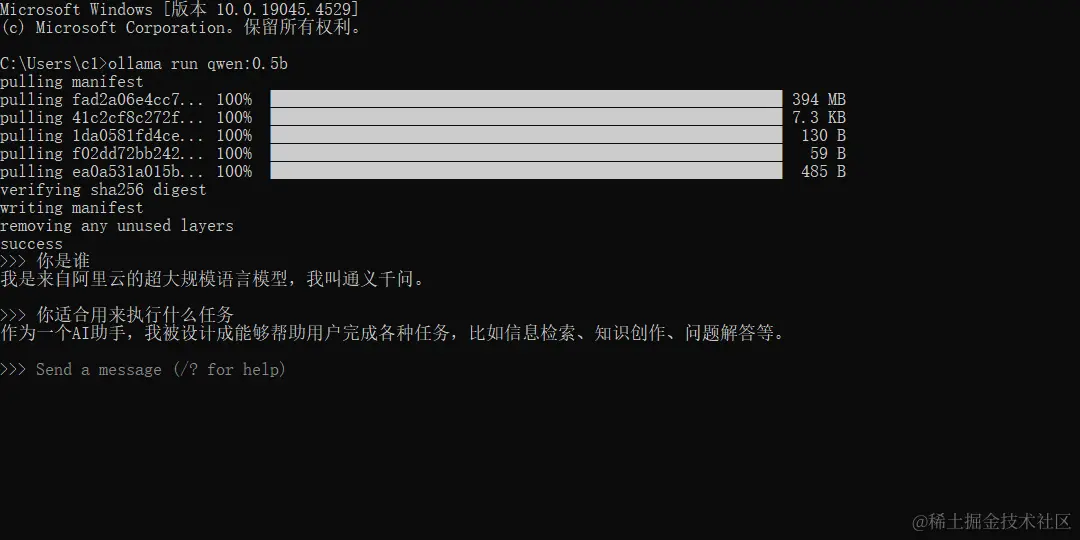

安装完毕后打开命令行黑窗口

开始菜单中找到命令提示符,点击打开

或者随便打开任意一个文件夹,然后在文件夹地址栏中输入 cmd 按回车。

都能打开一个黑窗口

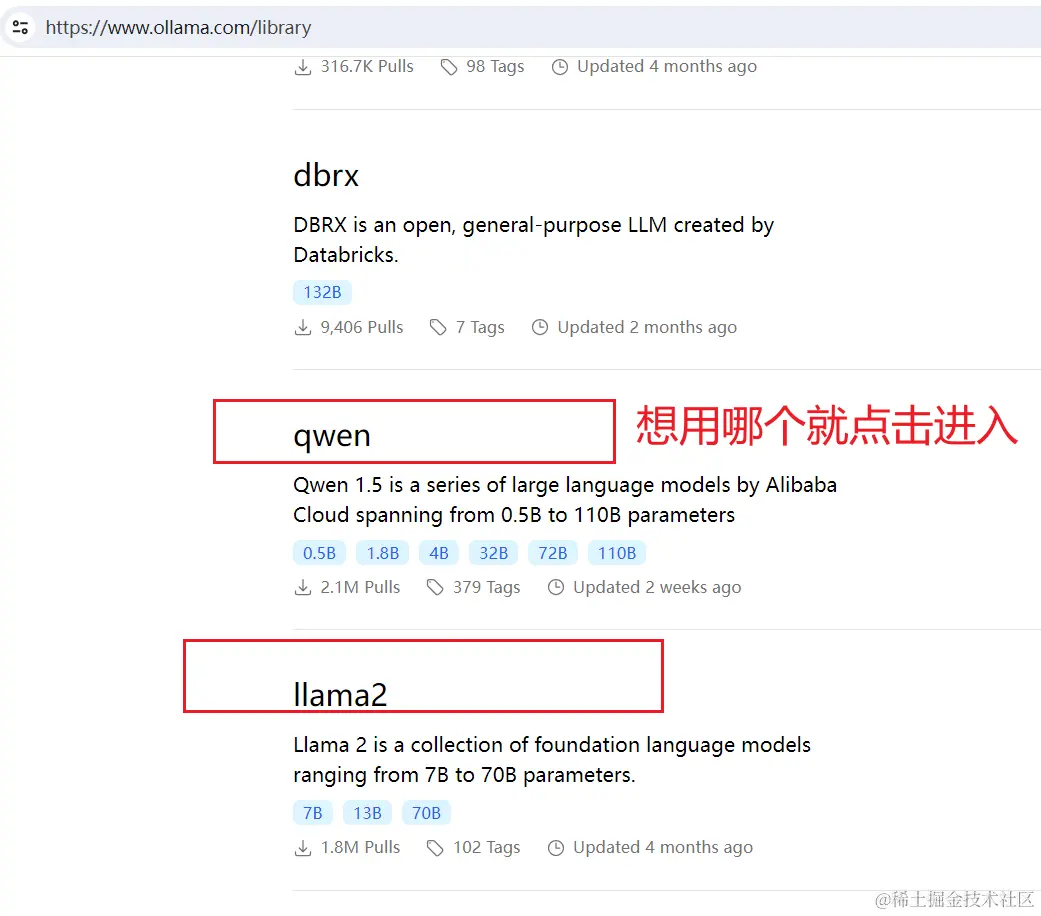

找到想要使用的模型,推荐 qwen系列

打开这个网址 www.ollama.com/library 可以选择要使用的模型

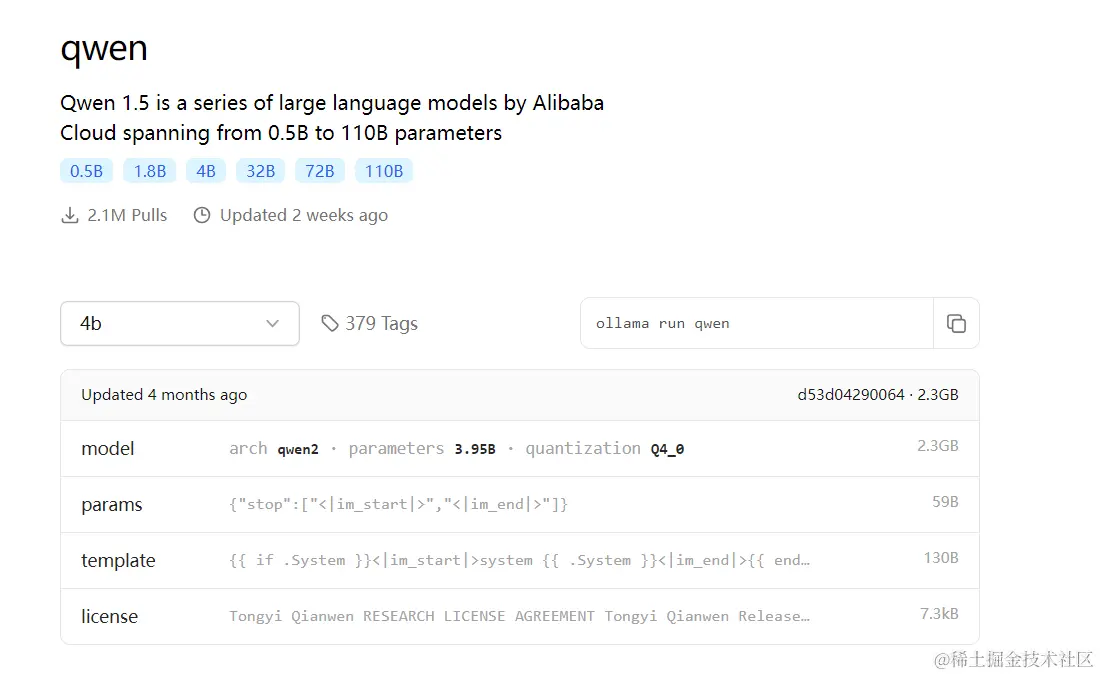

比如使用 qwen,点击进入后,会看到如下

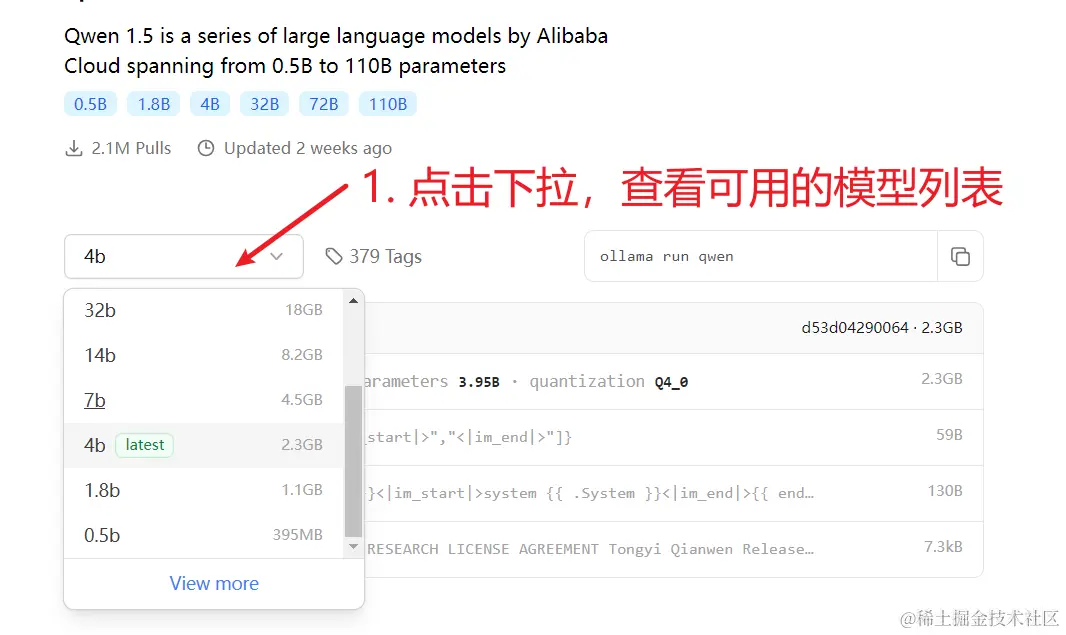

点击下拉框,可选择模型版本列表,4b 代表该模型有40亿参数,当然参数越大效果越好,但同样也要求你的电脑配置越高,不够高的话不仅运行慢,还可能卡死机。

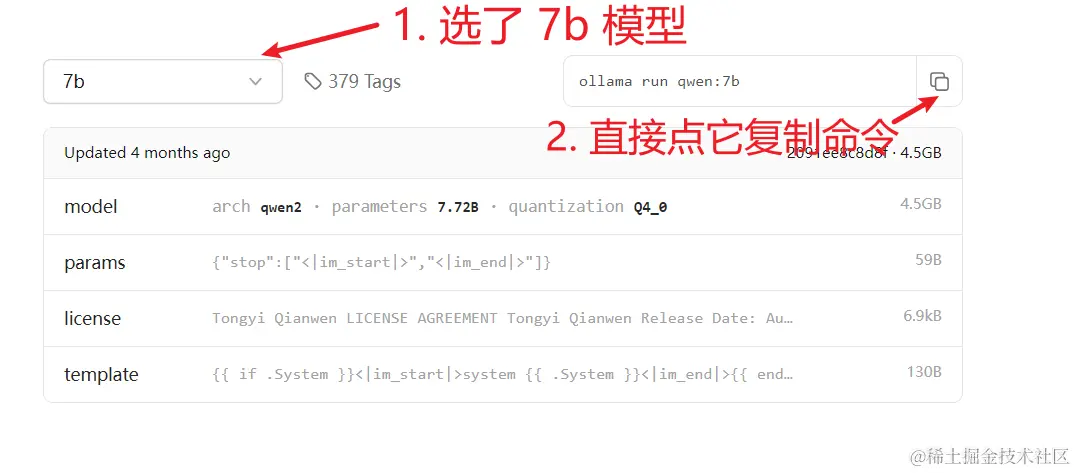

如果你有英伟达显卡,并且独立显存不低于12G,可以选择 14b / 32b 版本,否则建议选择 7b

选择后,右侧会显示对应的下载命令,点击复制图标复制该命令,以7b为例命令是 ollama run qwen:7b

复制后回到黑窗口,点击鼠标右键粘贴该命令,然后回车,就开始了下载,耐心等待下载完毕。

直接在黑窗口交互方式使用

上面下载完毕后,就可以直接在黑窗口中使用了,试试先询问它是谁吧

关闭了黑窗口,如何在次使用呢

还记得怎么打开cmd吗,用同样方法去打开它,然后同样去粘贴命令。7b的命令是ollama run qwen:7b

就自动打开了。

还想使用其他模型怎么办

同样方法,去 www.ollama.com/library 这个地址找到想用的模型,点击进入,选择模型版本,复制右侧命令,到 cmd黑窗口中粘贴回车。

cmd黑窗口太难用了,有没有ui界面

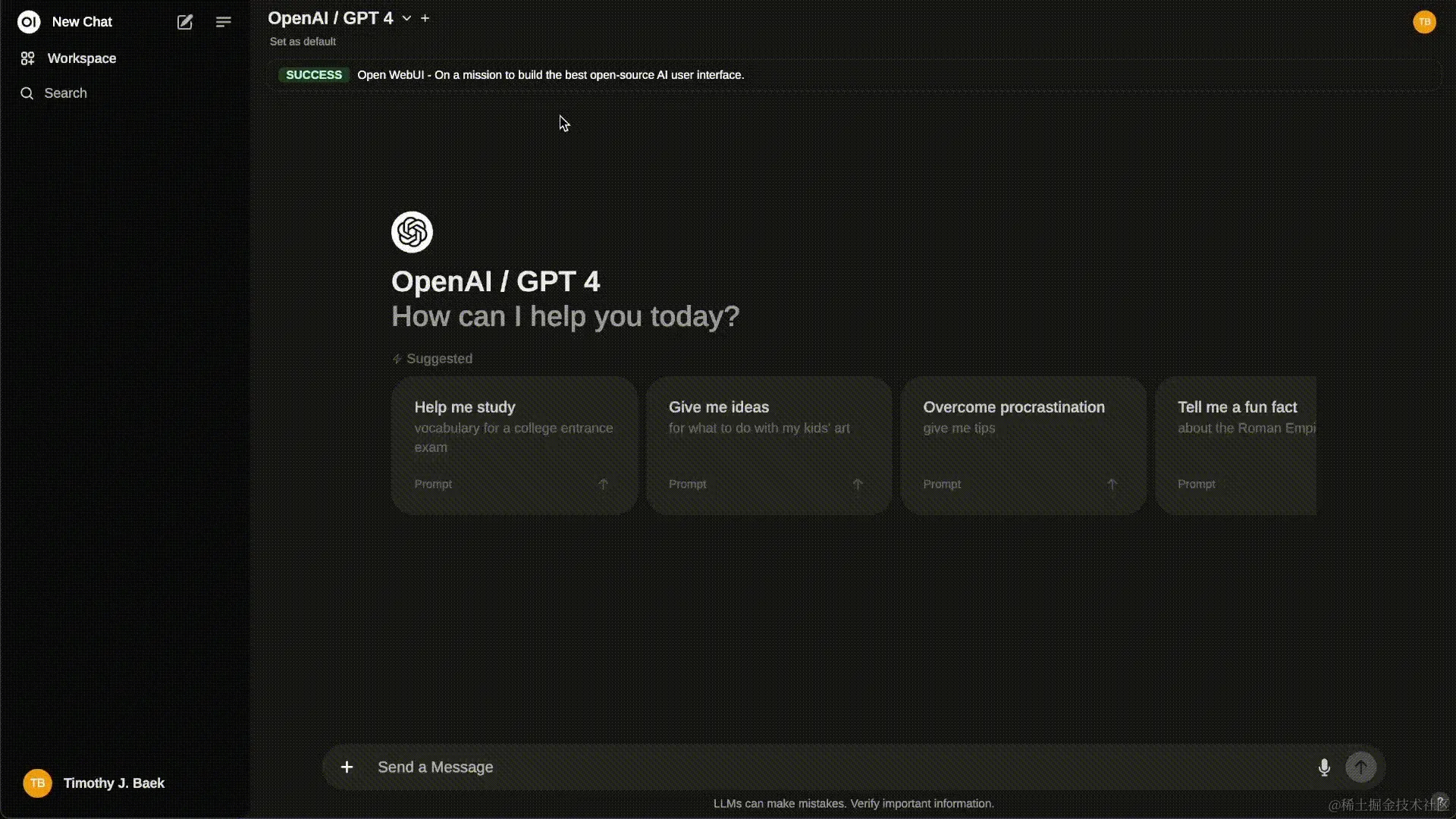

搭配 ollama 最好用的ui界面首推ollama官方的 docs.openwebui.com(使用的化建议使用docker快速安装)

如果你懂 docker部署或略懂代码,可参考手动安装。

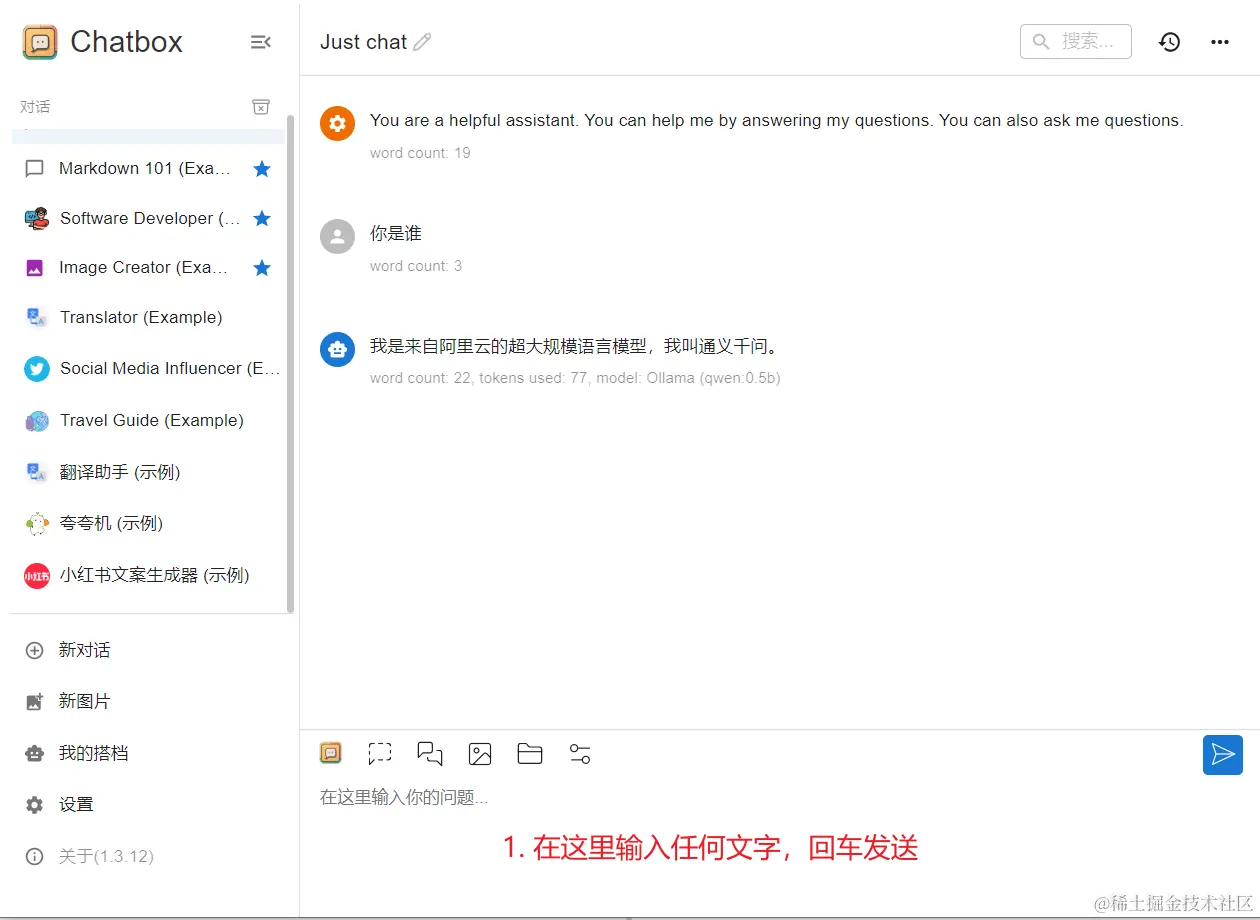

如果你只想下载一个exe鼠标点点就能使用,可下载 chatbox,双击安装,同安装其他软件一样方法

第一次运行点击设置

然后点击“显示”,再从下拉框里选择 “ollama”

然后在模型下拉框里选择你要使用的模型,所有通过 ollama run 命令安装的模型都会在此显示,选择好后点击保存

如果找不到模型,需要参考如何配置ollama远程模式配置环境变量,

在 MacOS 上配置

-

打开命令行终端,输入以下命令:

launchctl setenv OLLAMA_HOST "0.0.0.0" launchctl setenv OLLAMA_ORIGINS "*" -

重启 Ollama 应用,使配置生效。

在 Windows 上配置

在 Windows 上,Ollama 会继承你的用户和系统环境变量。

-

通过任务栏退出 Ollama。

-

打开设置(Windows 11)或控制面板(Windows 10),并搜索“环境变量”。

-

点击编辑你账户的环境变量。

为你的用户账户编辑或创建新的变量 OLLAMA_HOST,值为 0.0.0.0; 为你的用户账户编辑或创建新的变量 OLLAMA_ORIGINS,值为 *。

-

点击确定/应用以保存设置。

-

从 Windows 开始菜单启动 Ollama 应用程序。

在 Linux 上配置

如果 Ollama 作为 systemd 服务运行,应使用 systemctl 设置环境变量:

-

调用

systemctl edit ollama.service编辑 systemd 服务配置。这将打开一个编辑器。 -

在 [Service] 部分下为每个环境变量添加一行 Environment:

[Service] Environment="OLLAMA_HOST=0.0.0.0" Environment="OLLAMA_ORIGINS=*" -

保存并退出。

-

重新加载 systemd 并重启 Ollama:

环境变量配置好后,就可以选择对应模型之后进行聊天了。systemctl daemon-reload systemctl restart ollama